一、产品简介

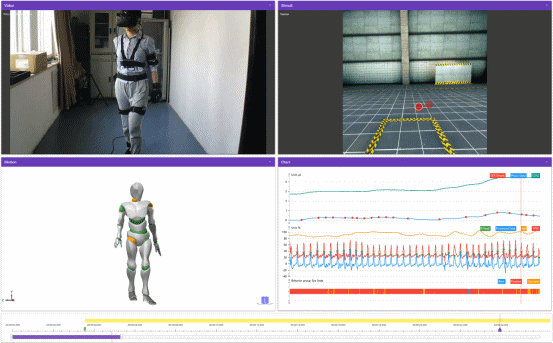

Xsens可穿戴式动作捕捉系统是一款无线便携、操作简易的惯性动作捕捉系统,适用于多种环境的人因工程与人机工效研究,包括标准实验室、物理模拟、智能驾驶模拟、虚拟现实以及真实现场等环境。系统基于先进的微型惯性传感器和无线通信解决方案,结合了先进的多维传感器融合算法,使用生物力学预测模型对动作行为数据进行采集与再现。系统结合ErgoLAB人机环境同步云平台,可将动作捕捉数据与多维度主客观人机环境数据进行同步采集与综合分析。

二、产品功能

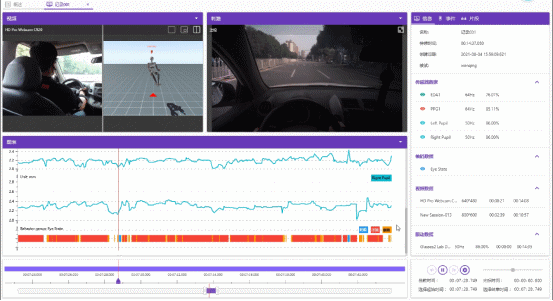

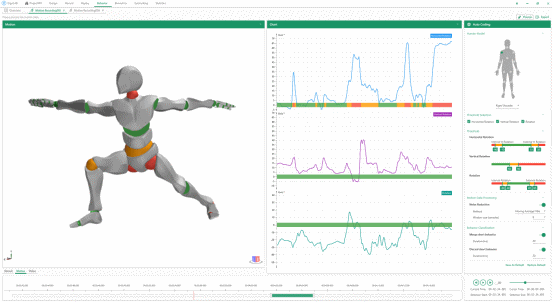

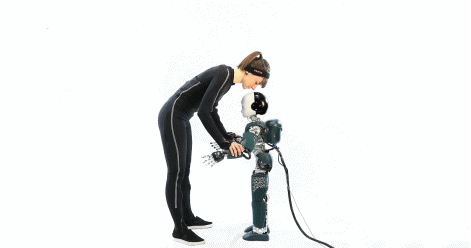

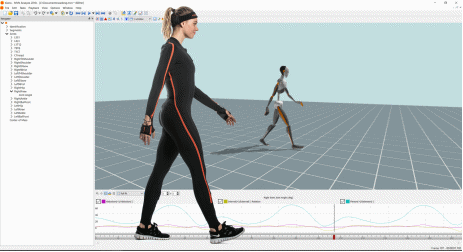

人体全身动作捕捉:通过配置的莱卡服、T恤、绑带、束发带、手套、鞋舌垫等配件,可以在人体全身各主要部位放置传感器,实现人体全身的动作捕捉。此外,系统配置了应用于道具的传感器,因此,研究人员可以对被试所使用工具的位置数据等进行实时捕捉,并利用这些数据在事后进行工效学分析。时空信息记录:通过系统中配备的GNSS空间定位系统,实时记录被试的位置信息,并结合行为及动作数据进行时空与交互行为分析,可用于空间设计规划等方面。动作及参数分析:实时记录被试的动作及使用道具的数据,研究人员可以在事后进行全身动作画面分析、姿态分析、受伤风险分析以及多维身体参数分析,包括身体重心、运动轨迹、关节角度、关节角速度、关节角加速度、身体运动速度、身体运动加速度以及身体数据捕捉等。人体工效及人机交互分析:研究人员可以在多种实验环境下进行人机工效的研究,并通过系统所记录的动作及工具数据,进行工效数据的分析;还可以进行人体工效学评价,包括动作姿态研究、姿势伤害分析等。例如,流水线作业环境安全性研究、无障碍设施设计评估、康复疗养仪器设计等。人工智能领域研究:可用于人工智能领域的相关研究,如进行机器人控制研究以及无人驾驶的研究。数据导出与分析:系统可以自动生成数据分析报告,此外,还可以导出多种格式的数据,使用Matlab、EXCEL、Unity、VIVE Lab等工具进行分析。数据缓存与重处理:系统硬件具有数据缓存的功能,确保数据不意外丢失;此外,系统软件具备重处理功能,通过高清重处理功能,可以提升数据质量,为研究者提供尽可能准确的数据。多模态数据同步采集与分析:通过ErgoLAB人机环境同步云平台,可将动作捕捉数据与多维度人因数据进行同步采集与分析,包括生理、脑电、眼动、功能性近红外脑成像、行为、面部表情、交互行为、模拟器、物理环境等数据。三、产品特点

操作简易,使用方便:系统佩戴方便,且校准步骤简易,从佩戴到校准到开始记录所需时间短、步骤少,便于操作。使用不受研究环境限制:系统可以在不同的研究环境中使用,不受限制,例如标准实验室、物理模拟、智能驾驶模拟、虚拟现实以及真实现场等环境。使用不受光线环境与空间限制:系统可以在不同光线环境中使用,且不受空间限制,在室内、室外均可使用。抗电磁干扰:系统抗电磁力强,可以在复杂的电磁环境中工作,如座舱驾驶环境等。传感器续航能力强:系统可连续记录6-9,5小时,续航能力强,确保长时间研究依然能够顺利进行。3D空间位移数据捕捉:系统可取得人体精准的空间位置数据,可以录制跳跃或快速奔跑的动作数据(可录制双脚同时离地、跳跃、爬楼等动作);传感器内部刷新率高达每秒1000Hz,使得动作数据更加精准。信号接收范围广:室内使用时,信号传输距离可达15~20m,室外使用时,信号传输距离可达50m。支持多人同步数据:一套软件支持四套硬件进行同步采集,通过多套系统串联可实现更多人数的团体测试,实现对多人交互行为等的研究。多模态数据同步采集与分析:系统通过ErgoLAB人机环境同步云平台,可以与多模态数据采集设备进行同步采集,包括生理数据、脑电数据、功能性近红外脑成像数据、眼动数据、行为数据、面部表情数据等。四、产品应用

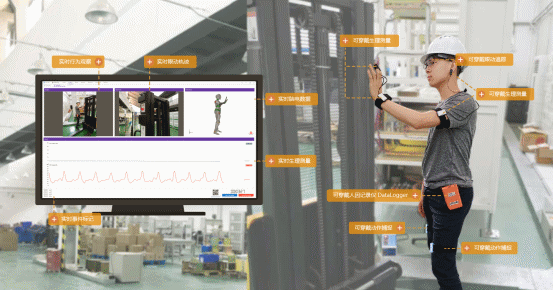

工业工程与安全工程领域:系统可以在不干扰工作人员正常工作的情况下,实时采集工作人员的动作数据和所用工具的位置数据等,研究人员可以使用数据进行人机工效学的分析,例如姿态分析、姿势伤害分析、交互行为分析等。工业设计与人机交互领域:系统可被用于在多种实验环境下,记录人机交互过程中人员的身体动作数据,这些数据可被用于研究设备的工效以及交互行为的效率;此外,还可以运用系统进行机器人控制等研究。国防与装备领域:可以在zuozhan 训练时使用系统记录动作及行为数据,以便提升训练质量及训练方法,此外,系统可用于装备测评,在使用新型装备时捕捉其动作及行为数据,对该装备的工效数据进行分析,以便对其进行改进。交通驾驶与行为安全领域:系统可被用于无人驾驶领域的研究,此外,由于系统具有强抗电磁力,系统可被用于在真实与模拟驾驶环境中采集驾驶人员动作、行为数据。五、科研支持与联合实验

津发科技具有完整的软硬件研发团队,支持联合订制开发,可与高校、科研院所等进行产学研合作,实现理论与算法结合转化科技成果;具有专业的科研实验团队,团队人员均具有专业研究背景,提供实验设计-数据采集-数据处理-统计分析全流程的联合科研与实验服务,搭建产学研合作与资源共享实验平台。

六、厂家介绍

北京津发科技股份有限公司是高新技术企业、科技部认定的科技型中小企业和中关村高新技术企业,具备自主进出口经营权;自主研发的人因工程与工效学相关技术、产品与服务荣获多项省部级科学技术奖励、国家发明、国家软件著作权和省部级新技术新产品(服务)认证;通过了欧洲CE、美国FCC、欧盟RoHS、ISO9001、ISO14001、OHSAS18001等多项国际认证和国家防爆认证。

津发科技设立人因工程专业的学术科研团队、技术团队及研发团队,并通过多年与科研机构及高校的产学研合作,积累了人因与工效学领域多项核心技术,以及基于机器学习等人工智能算法的状态识别和人机工效评价技术与研究方法等,是国内的人因工程技术创新中心!津发科技的实验室规划建设技术团队提供的技术支持及售后服务,从实验室建设的规划与布局,到设备的培训与指导,多角度的进行实验室建设的全生命周期的服务。